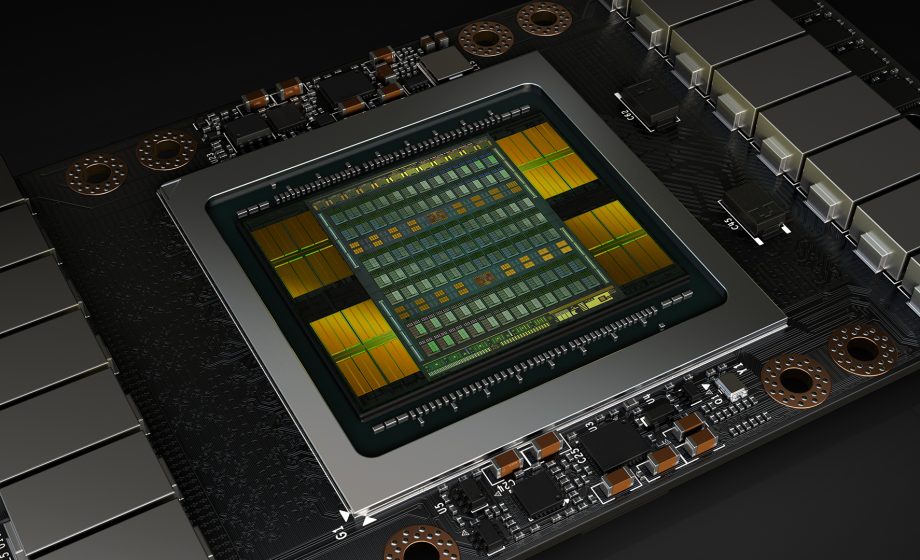

Nvidia vient de présenter sa nouvelle carte graphique, la Tesla V100, la première à intégrer sa puce Volta : surdimensionnée, d’une puissance pouvant atteindre 120 teraflops, elle est destinée avant tout à l’Intelligence Artificielle et au Deep Learning, dans des stations de travail haut de gamme pour des professionnels.

Plus de 3 milliards de dollars en recherche et développement : c’est ce qu’a investi Nvidia pour créer sa carte graphique Tesla V100, basée sur sa nouvelle architecture Volta. Le résultat est un monstre de puissance, pour l’instant réservé à des serveurs ou stations de travail professionnels, vendus entre 70 000 et 150 000 dollars.

Une puissance de 100 ordinateurs haut de gamme classiques

Gravée en 12nm, la puce Tesla V100 compte 21 milliards de transistors, sur une surface de 815 mm2 : il s’agit de la plus grosse puce construite, dépassant largement son aînée, la P100, et ses 15,3 milliards de transistors pour une surface de 610 mm2.

La Tesla V100 est composée de 5 120 coeurs CUDA et 640 coeurs tenseurs (Tensor Cores), permettant d’atteindre une puissance de 120 teraflops, et une puissance de calcul graphique pouvant atteindre 15 teraflops – à titre de comparaison la carte la plus haute de gamme disponible, la Titan X, offre un maximum de 12 teraflops. Cela lui offrirait la puissance d’une centaine de processeurs d’ordinateurs haut de gamme classiques.

Une Intelligence Artificielle qui apprend plus vite

Cette technologie permet un traitement très rapide des layers algorithmiques, spécifiques de l’apprentissage profond (Deep Learning en anglais), une branche centrale de l’IA : cette carte graphique permettrait donc d’accélérer considérablement la capacité d’apprentissage d’une Intelligence Artificielle.

Par ailleurs Nvidia étant agnostique, cette puissance d’apprentissage pourra s’appliquer aussi bien au secteur médical qu’à la recherche, l’ingénierie de pointe ou les transports autonomes. Autant de secteurs clés qui devraient être intéressés par cette nouvelle puce.

Un serveur boosté, qui ferait le travail de 400 serveurs actuels

Jen-Hsun Huang, directeur de Nvidia, a expliqué lors du lancement qu’un seul serveur DGX-1V, vendu 150 000 dollars et qui utilise huit puces Tesla V100, effectuerait le travail de 400 serveurs actuels. Sa puissance de calcul lui permettrait d’effectuer en 8 heures des opérations qui prendraient 8 jours avec un serveur équivalent équipés de Titan X.

Cela explique la présence, le jour de l’annonce, de géants du web comme Amazon, Facebook, Baidu, Microsoft ou encore Google, mais aussi de nombreux responsables de groupes industriels, médicaux, automobiles ou hi-tech : l’avenir de la Tesla V100 semble assuré.